SplineCam: Exact Visualization and Characterization of Deep Network Geometry and Decision Boundaries

Metadata

- Type: Journal Article

- Title: SplineCam: Exact Visualization and Characterization of Deep Network Geometry and Decision Boundaries,

- Author: Humayun, Ahmed Imtiaz; Balestriero, Randall; Balakrishnan, Guha; Baraniuk, Richard G,

Abstract

Current Deep Network (DN) visualization and interpretability methods rely heavily on data space visualizations such as scoring which dimensions of the data are responsible for their associated prediction or generating new data features or samples that best match a given DN unit or representation. In this paper, we go one step further by developing the first provably exact method for computing the geometry of a DN’s mapping – including its decision boundary – over a specified region of the data space. By leveraging the theory of Continuous Piece-Wise Linear (CPWL) spline DNs, SplineCam exactly computes a DN’s geometry without resorting to approximations such as sampling or architecture simplification. SplineCam applies to any DN architecture based on CPWL activation nonlinearities, including (leaky) ReLU, absolute value, maxout, and maxpooling and can also be applied to regression DNs such as implicit neural representations. Beyond decision boundary visualization and characterization, SplineCam enables one to compare architectures, measure generalizability, and sample from the decision boundary on or off the data manifold. Project website: bit.ly/splinecam.

当前深度网络(DN)的可视化和解释方法主要依赖于数据空间的可视化,例如评估哪些数据维度对其相关预测负责,或生成与给定的DN单元或表示最匹配的新数据特征或样本。在本文中,我们进一步发展了第一个可证明的方法,用于计算在数据空间的特定区域内,DN的映射几何结构,包括其决策边界。通过利用连续分段线性(CPWL)样条DN的理论,SplineCam可以精确计算DN的几何结构,而无需采用采样或架构简化等近似方法。SplineCam适用于基于CPWL激活非线性的任何DN架构,包括(leaky)ReLU、绝对值、maxout和最大池化,并且还可以应用于回归DN,例如隐式神经表示。除了决策边界的可视化和特征描述外,SplineCam还可以用于比较架构、测量泛化能力,并从数据流形上或离数据流形上的决策边界中进行抽样。项目网站:bit.ly/splinecam。

Intro

在本文中,我们专注于使用连续分段线性(CPWL)激活函数$\sigma$的深度网络(DNs),例如(leaky-)ReLU、绝对值和最大池化。在这种设置下,整个深度网络本身成为一个CPWL算子,即在其定义域的划分区域内,其映射是仿射的。之前的研究专注于估计这类CPWL DNs的划分,并将实证结果与可解释性相结合。例如,Raghu等人[34]表明划分密度提供了DN表现能力的度量,Hanin等人[13]将DN划分密度与学习函数的复杂性联系起来,Jordan等人[20]近似DN的划分以提供稳健性证书,Zhang等人[43]解释了与DN划分相关的dropout影响,Balestriero等人[3]提出改进批归一化以进一步适应数据几何的DN划分,Humayun等人[17, 18]提出通过近似DN划分来控制预训练生成网络的输出分布,Chen等人[25]提出了一种基于划分统计的神经网络架构搜索方法。尽管这些方法都取得了成功,但它们都依赖于DN划分的近似。

我们提出了SplineCam,一种无需采样的方法来精确计算DN的划分。我们的方法在输入空间的二维域上计算划分,可以轻松适应DN的宽度和深度,可以处理卷积层和跳跃连接,并且可以扩展到发现大量的区域,与之前的方法相比具有更高的可扩展性。我们的方法还允许基于划分统计对输入空间进行局部特征描述,并且能够有效地采样任意多个样本,这些样本可以证明位于DN的决策边界上 - 为可视化和解释提供了新的途径。我们总结我们的贡献如下:

- 我们开发了一种可扩展的枚举方法,它可以在给定有界的DN输入空间的二维域的情况下,计算DN的输入空间划分(也称为线性区域)和决策边界。

- 我们开发了SplineCam,利用我们新的枚举方法直接可视化DN的输入空间划分,计算划分统计量,并从决策边界进行采样。

- 我们进行了定量分析,证明了SplineCam对于表征DN、比较架构选择和训练方式的能力。我们展示了SplineCam在不同深度网络架构和训练策略下的性能,并通过具体指标和对比实验来量化其优势。这些结果证明了SplineCam作为一种强大的工具,可以帮助深度学习研究人员更好地理解和分析深度网络的性质和性能。

The Exact Geometry and Decision Boundary of Continuous Piece-Wise Linear Deep Networks

Deep Networks as Continuous Piece-Wise Linear Operators

非线性函数最基本的函数形式之一来自于多项式,尤其是样条运算符。一般来说,样条是一种映射,在输入空间分区Ω的每个区域ω上具有局部度为D的多项式,并且有额外的约束条件,即这些多项式的前D-1阶导数在整个定义域上连续,也就是在从一个区域到其任何相邻区域时施加了平滑性约束。更正式地说,在深度网络的背景下,我们将特别关注仿射样条,即具有D = 1且仅约束在整个定义域上保持连续性的样条运算符。

引理一:深度网络的第1层到$l$层的复合,记为$S^l$,其输出空间为$\mathbb R^l$,可以表示为:

其中

其中,$q_\omega^l$是激活函数$\sigma$在预激活$W^lz^{l-1}+b^l$处的逐点导数。根据Balestriero等人的定理,$q_\omega^l$对于任意一个区域$\omega \in\Omega$是唯一的。

这种对DN的表达方式之前已经被用于使理论研究适用于实际DN而无需任何简化,同时利用了关于样条理论的丰富文献,例如逼近理论、最优控制、统计学及相关领域。通过这种方式,可以更好地理解和分析DN的性质,并将理论研究与实际应用相结合。

Exact Computation of Their Partition and Decision Boundary

假设$w_i^l$和$b_i^l$分别$W^l,b^l$的第i行。通过下面的引理2可以把第$l$层输入空间$\mathbb R^{l-1}$的一个超平面$h^l_i$反向映射到输入空间$R^S$中。$h_i^l$的定义如下:

为啥把一层的超平面定义成这样呢?我觉得是因为CPWL每一层的激活函数都在0处分界,故这个超平面就是这一层的分界平面。

引理2:给定一个超平面$h^l_i\in \mathbb R ^{l-1}$,这个超平面可以被映射到源域$\omega\in \Omega\in \mathbb R^S$中,as:

其实把前$l-1$层整体看作是一个CPWL,把CPWL的表达式代入h的定义就可以了。

定理1:假设$S$是一个二分类的DN,因此其输出是一个单一的神经元。在$\mathbb R^{L-1}$空间中,它的决策边界是超平面$h_1^L$。$\mathbb R^S$中的决策平面是$\bigcup_{\omega\in \Omega}\{proj_\omega(h_1^L)\cap\omega\}$ 。

尽管如此,为了方便可视化,我们还是想在一个二维多面体$P \in R^S$上计算$\Omega$。

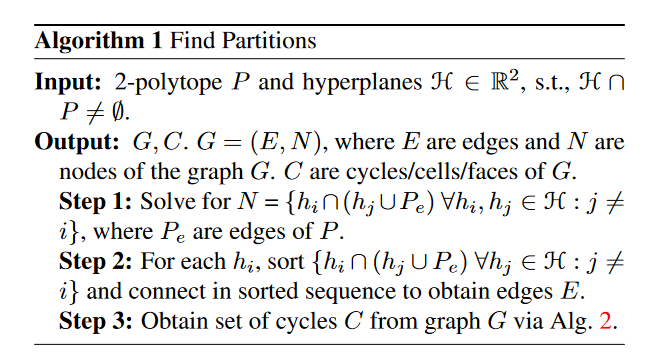

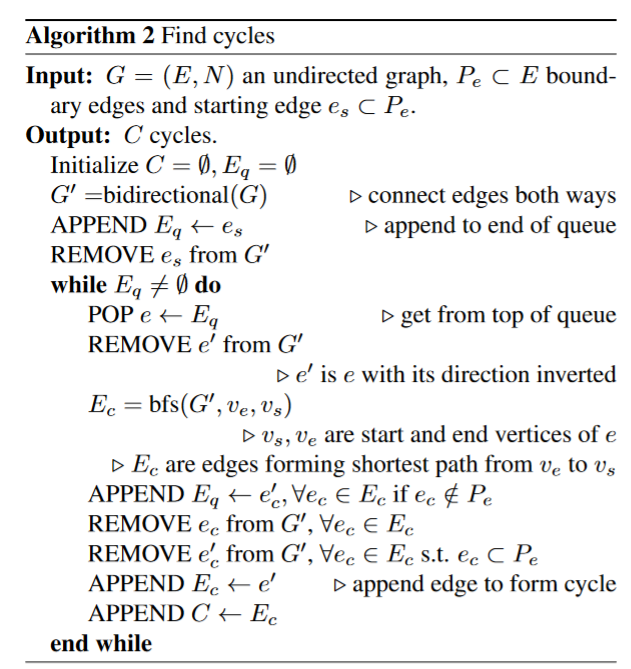

SplineCam:记第$1 \to l$层组成的输入空间中的划分为$\Omega_l$。使用算法1,SplineCam首先利用超平面$h_i^1$把$P$分割为$\Omega_1$。接着,对于$\forall \omega\in \Omega_1$,使用引理1和引理2获得$proj_w(h_i^2)$。接着在每个区域$\omega$上使用算法1来获得下一步的划分$\Omega_2$。以此类推可以得到$\Omega_L$。

算法1利用给定的边界和线来计算图中的点和边。算法2 利用算法1的结果计算图中的环,即$\omega$。

Visualizing and Understanding Implicit Neural Representations

下面开始探讨深度网络的几何学,首先从隐式神经表示(INRs)入手。INRs通常是多层感知器(MLPs),经过训练能够将一维、二维或三维信号坐标映射为对应坐标处信号的强度。在3D视图合成和逆问题等应用中,它们被广泛使用。由于INRs具有低输入维度和基本函数的可解释性,因此它们是定性验证SplineCam的良好背景。目前,对于现有INR实践缺乏理论理解[42]。例如,虽然ReLU MLP主要用于NeRF[26]等最流行的INR应用,但当前的实践已经转向使用周期性激活来编码输入坐标,并随后使用ReLU MLP。在本节中,我们将研究周期性编码的影响,并可视化INR学习的区域几何结构。

Decision Boundary of Signed Distance Functions

有符号距离函数(SDF)是一个隐式的连续表面或边界表示;SDF的输出是输入距离所表示边界的有符号距离。因此,SDF的零级集表示函数的表面或边界。将INR训练成有符号距离函数本质上是一个回归任务,模型通过拟合地面真实距离场来隐式地学习连续边界。我们训练了一个2D和一个3D的SDF,并使用我们的方法可视化了解析的零级集(类似于决策边界),并在图1和图5中提供了函数学习的样条划分。

SDF 的概念可以参考这个知乎专栏。属于2d或者3d模型的隐式存储方式。这篇论文使用神经网络来做SDF,具体来说就是使用神经网络记住空间中每个点与模型表面的距离。如果这个点在模型的内部,则这个距离为负数,如果点在外部,则这个距离为正数。如果点正好的模型的表面,则距离为0。